Crawl hay Crawling đóng vai trò quan trọng trong việc giúp các công cụ tìm kiếm khám phá và truy cập trang web của bạn. Quá trình crawl là một bước quan trọng trong việc lập chỉ mục các trang trên web của bạn. Trong bài viết này, chúng ta sẽ tìm hiểu Crawl là gì trong SEO và tại sao nó lại quan trọng như vậy.

Crawl là gì?

Crawl là gì? Crawl (thu thập dữ liệu) là quá trình mà các công cụ tìm kiếm sử dụng web crawler (còn được gọi là bot, spider hoặc trình thu thập dữ liệu) để truy cập vào các trang web trên internet.

Các bot hoạt động bằng cách theo dõi các liên kết trên trang web. Thông qua các liên kết, robot sẽ đi từ trang chủ của một trang web đến các trang con và sau đó tiếp tục theo dõi các liên kết khác trên các trang đó. Quá trình này tiếp tục diễn ra cho đến khi tất cả các liên kết đều được thu thập dữ liệu.

Trong khi crawl, bot sẽ thu thập thông tin về cấu trúc của trang web, nội dung của các trang, URL, từ khóa, tiêu đề, hình ảnh và các yếu tố khác. Tất cả các thông tin này sau đó được gửi về cho công cụ tìm kiếm để lập chỉ mục và xếp hạng trang web.

Công dụng của Crawl là gì với Google Search?

Google Search (hay Google Tìm kiếm) là công cụ tìm kiếm hoàn toàn tự động sử dụng phần mềm được gọi là Web crawler để thu thập dữ liệu. Web crawler sẽ định kỳ vào các trang web để tìm kiếm các trang mới và gửi dữ liệu về để thêm chỉ mục.

Trên thực tế, phần lớn các trang xuất hiện trên SERP không được gửi index thủ công mà được các web crawler tìm thấy và tự động gửi index. Google Tìm kiếm hoạt động theo ba giai đoạn và không phải trang nào cũng vượt qua cả 3 giai đoạn:

- Crawling – Thu thập thông tin: Google tải xuống văn bản, hình ảnh và video từ các trang tìm thấy trên internet bằng các chương trình tự động được gọi là trình thu thập thông tin.

- Indexing – Lập chỉ mục: Google phân tích các tệp văn bản, hình ảnh và video trên trang và lưu trữ thông tin trong chỉ mục của Google, đây là một cơ sở dữ liệu lớn.

- Cung cấp kết quả tìm kiếm: Khi người dùng tìm kiếm trên Google, Google sẽ trả lại thông tin có liên quan đến truy vấn của người dùng.

Bước 1: Crawling (Thu thập dữ liệu)

Crawling là bước đầu tiên trong quá trình xếp hạng các trang web trên internet. Không có một trung tâm đăng ký nào để ghi nhận những website và nội dung mới trên mạng. Chính vì vậy Google phải liên tục tìm kiếm các trang mới và cập nhật vào danh sách cần thu thập dữ liệu của mình. Quá trình này được gọi là “khám phá URL” (URL discovery).

Một số trang được biết đến vì Google đã từng khám phá ra chúng. Một số trang khác lại được phát hiện khi Googlebot đi theo một liên kết từ một trang A (trang đã biết) đến một trang B (trang mới). Một số trang thì được phát hiện khi chủ sở hữu website gửi sitemap (sơ đồ trang web) thông báo cho Google.

Sau khi Google phát hiện ra URL của một trang, nó sẽ “cử” các bot truy cập trang web để bắt đầu thu thập thông tin. Đó là cách mà Google thu thập dữ liệu của hàng tỷ trang web trên internet từ khắp thế giới.

Tuy nhiên, Googlebot sẽ không thể thu thập dữ liệu tất cả các trang mà nó đã phát hiện. Việc thu thập thông tin phụ thuộc vào việc trình thu thập thông tin của Google có thể truy cập trang web hay không. Một số vấn đề khiến Googlebot gặp khó khăn khi truy cập các trang web bao gồm:

- Sự cố với máy chủ xử lý trang web

- Sự cố mạng

- Quy tắc robots.txt chặn web crawler

- Mã lỗi HTTP (lỗi 404, 500, 503)

Bước 2: Indexing (Lập chỉ mục)

Sau khi một trang đã được crawl, Google sẽ cố gắng để hiểu nội dung của trang đó. Giai đoạn này được gọi là lập chỉ mục và nó bao gồm việc xử lý và phân tích nội dung văn bản, các thẻ tag, tiêu đề, thẻ alt, hình ảnh, video và nhiều hơn nữa. Trong quá trình lập chỉ mục, Google xác định xem trang đó có trùng lặp với trang khác trên internet hay không.

Trang gốc (canonical) là trang được ưu tiên hiển thị trong kết quả tìm kiếm. Để chọn trang gốc, Google sẽ nhóm các trang web có nội dung tương tự lại với nhau và chọn ra trang có nội dung đầy đủ nhất đại diện cho nhóm đó. Các trang còn lại là các phiên bản thay thế có thể được hiển thị cho các ngữ cảnh tìm kiếm khác.

Bên cạnh đó, không phải trang nào cũng sẽ được Google lập chỉ mục. Một số vấn đề có thể khiến việc lập chỉ mục gặp khó khăn là:

- Robots.txt chặn các công cụ tìm kiếm lập chỉ mục

- Meta Tags: Thẻ meta “noindex” được sử dụng để ngăn trang không được lập chỉ mục.

- Chính sách riêng tư của trang

- Lỗi kỹ thuật trên trang

- Trang mới: mất một thời gian cho các công cụ tìm kiếm để phát hiện và lập chỉ mục trang mới.

- Bị xóa: Trang web có thể bị xóa khỏi chỉ mục vì vi phạm bản quyền, spam hoặc lừa đảo.

Bước 3: Cung cấp kết quả tìm kiếm

Khi người dùng nhập truy vấn, bộ máy của Google sẽ tìm kiếm chỉ mục cho các trang phù hợp và trả về kết quả mà nó tin là có chất lượng cao nhất và phù hợp nhất. Mức độ liên quan được xác định bởi hàng trăm yếu tố, kể cả các thông tin như vị trí, ngôn ngữ và thiết bị của người dùng (máy tính để bàn hoặc điện thoại).

Tùy thuộc vào truy vấn của người dùng mà kết quả hiển thị trên trang kết quả tìm kiếm cũng thay đổi, chẳng hạn như khi dùng từ ngữ tìm kiếm khác nhau. Ví dụ: khi tìm kiếm từ khóa “mô hình SWOT” và từ khóa “phân tích SWOT” thì kết quả trên SERP sẽ khác nhau dù có chung mục đích tìm kiếm.

10 cách giúp để tăng tốc độ Crawl hiệu quả

Để quá trình crawl website diễn ra thuận lợi hơn, bạn có thể thực hiện các phương pháp sau:

1. Thêm nội dung mới đều đặn

Một trong những tiêu chí quan trọng nhất khi đánh giá một website đối với các công cụ tìm kiếm là nội dung. Các trang web cập nhật nội dung thường xuyên có cơ hội được ưu tiên thu thập dữ liệu thường xuyên. Để cải thiện tốc độ thu thập dữ liệu của Google, bạn nên đăng nội dung mới ít nhất ba lần trong một tuần.

2. Cải thiện tốc độ tải trang

Trình thu thập dữ liệu có thời gian giới hạn để lập chỉ mục trang web của bạn. Nếu nó dành quá nhiều thời gian để truy cập hình ảnh hoặc tệp pdf, nó sẽ không có thời gian để xem các trang khác. Để tăng tốc độ tải trang web của bạn, các trang nên có ít hình ảnh và đồ họa hơn. Ngoài ra, hãy nhớ rằng video hoặc âm thanh được nhúng vào website có thể gây khó khăn cho bot thu thập dữ liệu.

3. Gửi Sitemap

Mọi nội dung trên trang web đều phải được thu thập thông tin, nhưng đôi khi sẽ mất nhiều thời gian hoặc tệ hơn là… không bao giờ. Gửi sitemap (sơ đồ trang web) là một trong những điều quan trọng bạn phải làm để Googlebot có thể tìm thấy trang web của bạn. Nhờ đó, trang web có thể được thu thập dữ liệu một cách hiệu quả hơn.

4. Giảm thời gian phản hồi của máy chủ

Theo Google, bạn nên giảm thời gian phản hồi của máy chủ xuống dưới 200 ms. Nếu thời gian phản hồi của máy chủ chậm, các trang của bạn sẽ load chậm hơn. Bạn có thể thấy cảnh báo của Google về điều này ở mục “crawl rate” trên Google Search Console. Ngoài ra, hãy sử dụng dịch vụ hosting hiệu quả và cải thiện bộ nhớ cache của trang web.

5. Tránh trùng lặp nội dung

Nội dung sao chép sẽ làm giảm tốc độ thu thập dữ liệu của Google vì các công cụ tìm kiếm có thể dễ dàng xác định nội dung trùng lặp. Nội dung trùng lặp là bằng chứng rằng bạn thiếu tính sáng tạo và mục đích tích cực. Nếu các trang của bạn có nội dung trùng lặp vượt quá một mức nhất định, các công cụ tìm kiếm có thể hạ thứ hạng của chúng trên SERP.

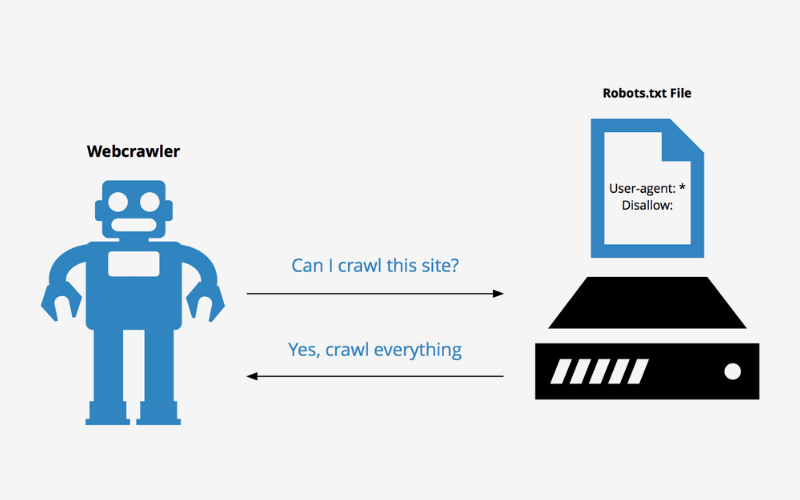

6. Chặn các trang không mong muốn bằng Robots.txt

Nếu bạn có một trang web lớn, bạn có thể có nội dung mà bạn không muốn công cụ tìm kiếm lập chỉ mục. Ví dụ, trang quản trị và các thư mục backend. Robots.txt có thể ngăn Googlebot thu thập dữ liệu các trang không mong muốn đó.

Tuy nhiên, việc sử dụng chúng có thể phức tạp và nếu bạn mắc lỗi, nó có thể khiến trang web của bạn bị loại khỏi danh sách lập chỉ mục của công cụ tìm kiếm. Vì vậy, hãy luôn kiểm tra tệp robots.txt của bạn bằng cách sử dụng Google Webmaster tools trước khi tải lên.

7. Tối ưu hình ảnh

Khi hình ảnh được tối ưu hóa, chúng có thể được hiển thị trong kết quả tìm kiếm. Bot sẽ không thể đọc hình ảnh trực tiếp như con người. Bất cứ khi nào bạn sử dụng hình ảnh, hãy đảm bảo sử dụng thẻ alt và cung cấp mô tả để công cụ tìm kiếm lập chỉ mục.

8. Xây dựng backlink chất lượng

Các backlink chất lượng cao sẽ cải thiện tốc độ thu thập dữ liệu của Google và lập chỉ mục cho trang web. Đó cũng là cách hiệu quả nhất để được xếp hạng tốt hơn và thu hút nhiều lưu lượng truy cập. Lưu ý rằng không nên mua hoặc ăn cắp backlink và nên sử dụng phương pháp đi backlink mũ trắng.

9. Đi internal link

Khi sử dụng internal link (liên kết nội bộ), Googlebot có thể thu thập dữ liệu kỹ càng hơn trên website của bạn. Bài viết này liên kết với bài viết khác, liên kết bài viết cũ với bài viết mới sẽ giúp tăng tốc độ thu thập dữ liệu và cải thiện khả năng hiển thị với người dùng.

10. Tăng lượt share social

Không có bằng chứng nào cho thấy các lượt chia sẻ trên mạng xã hội sẽ ảnh hưởng đến xếp hạng trên SERP nhưng chúng giúp nội dung mới được lập chỉ mục nhanh chóng. Chẳng hạn, Facebook không cho phép bot thu thập thông tin không công khai.

Tuy nhiên, Googlebot có thể truy cập thông tin có sẵn công khai trên các phương tiện truyền thông xã hội. Do đó, việc nhận được một lượng chia sẻ kha khá cho nội dung của bạn trên mạng xã hội sẽ giúp trang được thu thập dữ liệu và lập chỉ mục nhanh chóng.

Lời kết

Crawl là một quá trình cần thiết để trang web được lập chỉ mục và xuất hiện trên SERP với người dùng. Bài viết trên đã giúp bạn hiểu được crawl là gì và hướng dẫn những cách để quá trình thu thập dữ liệu diễn ra thuận lợi hơn. Hy vọng bài viết trên đã giúp bạn hiểu được thuật ngữ này và đừng bỏ qua những bài viết tiếp theo của Miko Tech nhé!

Trần Tiến Duy tốt nghiệp cử nhân chuyên ngành Thương Mại Điện tử tại trường đại học Sư Phạm Kỹ Thuật TPHCM. Từng Phụ trách mảng SEO Website tại nhiều lĩnh vực như giáo dục, công nghệ, thực phẩm, đồ dùng gia dụng, …v.v

Trần Tiến Duy hiện đang là Giảng viên Digital Marketing với chuyên môn chính là SEO tại trường Cao Đẳng FPT Tp.HCM.

Với hơn 5+ năm kinh nghiệm training & quản lý nhân sự về quản lý các dự án SEO/ Content SEO.

Hiện tại Trần Tiến Duy là SEO Manager tại công ty Miko Tech Agency chuyên về Thiết Kế Website, với sự Quản lý của anh đã đưa Miko Tech trở thành công ty chuyên về Thiết Kế Website thuộc TOP ngành trên nền tảng Internet hiện nay. Ngoài ra anh Trần Tiến Duy còn đào tạo training nhân viên. Ngoài ra anh Trần Tiến Duy còn đào tạo training nhân viên khoá học SEO Website nội bộ cho Doanh nghiệp giúp Doanh Nghiệp tối ưu tốc độ website phát triển kinh doanh mạnh mẽ hơn trong thời đại công nghệ số 4.0 hiện nay.

Anh Trần Tiến Duy còn chia sẻ miễn phí những Tool SEO hiệu quả giúp anh em SEOer tiết kiệm thời gian và được rất nhiều anh em trong giới SEOer và sinh viên sử dụng tại website: trantienduy.com/tool/