Robots.txt là gì? Trên thực tế, robots.txt là một tệp tin quan trọng mà hầu hết các chủ trang web sử dụng để quản lý cách mà các bot và công cụ tìm kiếm hoạt động trên trang của họ. Trong bài viết này, chúng ta sẽ tìm hiểu chi tiết hơn về robots.txt, cách tệp tin này hoạt động và vai trò của nó trong việc quản lý việc thu thập dữ liệu của trang web.

Robots.txt là gì?

Robots.txt là gì? Robots.txt là một tập tin văn bản mà quản trị viên trang web có thể sử dụng để ngăn các trình thu thập dữ liệu web như Googlebot, Bingbot và các robot khác thu thập dữ liệu một số trang web hoặc các tài nguyên nhất định trên trang.

Giả sử trang web của bạn có nhiều phần khác nhau như trang chủ, trang sản phẩm, trang blog, và bạn muốn cho phép các công cụ tìm kiếm như Google tìm kiếm và hiển thị trang chủ và trang sản phẩm, nhưng không muốn chúng truy cập vào trang blog. Bằng cách sử dụng tệp tin robots.txt, bạn có thể kiểm soát và chỉ định những trang web mà các robot được phép hoặc không được phép truy cập.

Vì sao file robots.txt được sử dụng?

File robots.txt có vai trò quan trọng trong việc điều khiển và quản lý hoạt động của các robot và công cụ tìm kiếm trên trang web:

Kiểm soát truy cập

Robots.txt cho phép bạn quyết định rõ ràng và kiểm soát truy cập của các robot và công cụ tìm kiếm vào các phần của trang web. Bạn có thể chỉ định những phần cụ thể mà bạn muốn cho phép bot truy cập, giúp bảo vệ sự riêng tư cho các phần quan trọng của trang web. Nếu bạn phát hiện một robot hoặc công cụ tìm kiếm không đáng tin cậy, bạn có thể sử dụng robots.txt để từ chối yêu cầu truy cập từ chúng.

Tiết kiệm tài nguyên

Khi robot hoặc công cụ tìm kiếm truy cập vào trang web, nó tốn tài nguyên của máy chủ và thời gian tải trang. Bằng cách sử dụng robots.txt, bạn có thể chỉ định rằng các robot không nên truy cập vào các phần không cần thiết hoặc tài nguyên lớn, giúp giảm tải trọng cho máy chủ và tăng tốc độ tải trang.

Bảo vệ nội dung

Robots.txt giúp bảo vệ nội dung quan trọng và giữ cho các trang web chuyên dụng không bị chỉ mục. Ví dụ, nếu bạn có các trang hoặc phần không muốn xuất hiện trong kết quả tìm kiếm, bạn có thể chỉ định trong robots.txt để ngăn các robot tìm kiếm lập chỉ mục chúng.

Tối ưu hóa tìm kiếm

Sử dụng robots.txt đúng cách có thể giúp tối ưu hóa quá trình tìm kiếm và hiển thị nội dung quan trọng trên trang web của bạn. Bằng cách chỉ định rõ ràng các phần được phép truy cập và lập chỉ mục, bạn đảm bảo rằng các robot tập trung vào nội dung quan trọng nhất và không lãng phí thời gian và tài nguyên cho các phần không quan trọng.

Tối ưu quá trình Crawl

Thông thường, các công cụ tìm kiếm sẽ crawl (thu thập dữ liệu) nội dung trang web trong một khoảng thời gian nhất định. Nếu trang web của bạn có quá nhiều trang và không sử dụng robots.txt, bot sẽ không biết nên ưu tiên crawl trang nào và chúng có thể lập chỉ mục những trang không quan trọng. Bằng cách sử dụng robots.txt, bạn có thể chỉ định các trang mà bot nên tập trung lập chỉ mục.

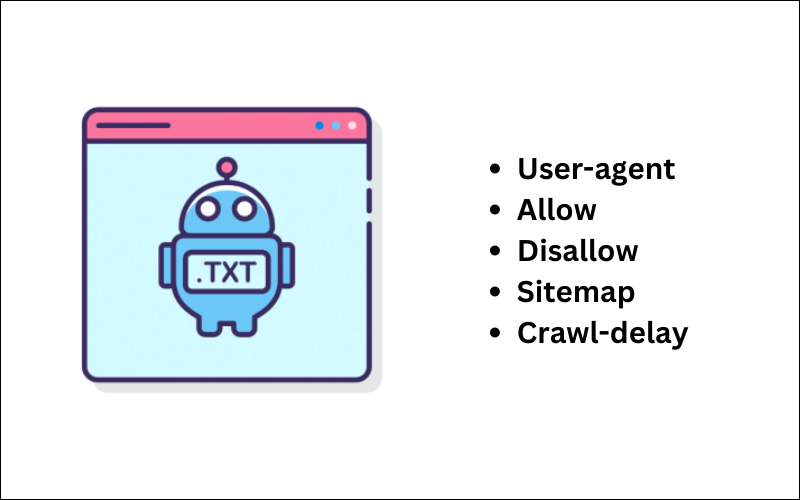

Cấu trúc file robots.txt là gì?

Tệp robots.txt là một tệp văn bản đơn giản có thể được sử dụng để ngăn trình thu thập dữ liệu của các công cụ tìm kiếm truy cập các trang web nhất định. Tệp này nằm ở thư mục gốc của trang web của bạn và có thể được chỉnh sửa bằng bất kỳ trình soạn thảo văn bản nào.

Lệnh Disallow

Cấu trúc của tệp robots.txt rất đơn giản. Tệp bắt đầu với dòng tiêu đề “User-agent: “, theo sau là tên của trình thu thập dữ liệu mà bạn muốn ngăn truy cập các trang web của mình. Sau đó, tệp có thể chứa một số dòng “Disallow: “, theo sau là URL của trang web mà bạn muốn ngăn bot truy cập.

Ví dụ: nếu bạn muốn ngăn Googlebot truy cập trang web “/secret-page.html”, bạn có thể thêm dòng sau vào tệp robots.txt của mình:

User-agent: Googlebot

Disallow: /secret-page.htmlLệnh Allow

Bạn cũng có thể sử dụng tệp robots.txt để chỉ định các trang web mà bạn muốn trình thu thập dữ liệu ưu tiên truy cập. Để thực hiện việc này, hãy sử dụng cú pháp “Allow: “. Ví dụ: nếu bạn muốn Googlebot ưu tiên truy cập trang web “/home.html”, bạn có thể thêm dòng sau vào tệp robots.txt của mình:

User-agent: Googlebot

Allow: /home.htmlLệnh Sitemap

Sitemap là một tệp XML chứa thông tin về cấu trúc và liên kết của trang web để giúp các công cụ tìm kiếm hiểu rõ hơn về nội dung của trang web. Khi robot tìm thấy lệnh Sitemap trong robots.txt, nó sẽ truy cập vào tệp sitemap.xml để xem thông tin về cấu trúc trang web và các liên kết liên quan.

Ví dụ, nếu bạn có một tệp sitemap.xml nằm ở đường dẫn “http://www.example.com/sitemap.xml”, bạn có thể thêm sitemap vào tệp robots.txt như sau:

Sitemap: http://www.example.com/sitemap.xmlViệc cung cấp tệp sitemap.xml trong tệp robots.txt giúp công cụ tìm kiếm như Googlebot hoặc Bingbot tìm thấy và khám phá nhanh chóng các trang trong trang web của bạn, đảm bảo rằng không có trang quan trọng bị bỏ sót trong quá trình thu thập thông tin.

Lệnh crawl-delay

Lệnh crawl-delay trong robots.txt là một chỉ thị cho bot của công cụ tìm kiếm đợi một khoảng thời gian nhất định trước khi thu thập dữ liệu một trang web. Điều này có thể hữu ích nếu bạn có một trang web lớn với nhiều trang và bạn muốn đảm bảo rằng trình thu thập dữ liệu không tải quá nhiều tài nguyên trên máy chủ của bạn.

Cấu trúc của lệnh crawl-delay là:

crawl-delay: <number>Trong đó <number> là số giây mà trình thu thập dữ liệu nên đợi trước khi thu thập dữ liệu trang tiếp theo. Ví dụ, với lệnh “crawl-delay: 10” sẽ khiến trình thu thập dữ liệu đợi 10 giây trước khi thu thập dữ liệu trang tiếp theo.

Những hạn chế của tệp tin robots.txt là gì?

Đúng, robots.txt không thể chặn việc lập chỉ mục trang web và không hoạt động với tất cả các công cụ tìm kiếm và bot khác. Dưới đây là những điểm cần lưu ý khi sử dụng robots.txt:

Không chặn việc lập chỉ mục trang web

Robots.txt chỉ là một hướng dẫn cho robot tìm kiếm và không thể ngăn chặn công cụ tìm kiếm lập chỉ mục các trang web. Nếu có các trang khác trỏ đến trang web của bạn, Google vẫn có thể lập chỉ mục cho trang web đó. Để ngăn chặn điều này, bạn cần sử dụng phương pháp khác, chẳng hạn như thẻ noindex.

Chỉ áp dụng cho một số công cụ tìm kiếm

Mặc dù robots.txt được chấp nhận bởi các công cụ tìm kiếm phổ biến như Googlebot và Bingbot, không phải tất cả các công cụ tìm kiếm đều sẽ tuân thủ nó. Một số bot tìm kiếm khác có thể bỏ qua lệnh trong tệp robots.txt và tiếp tục thu thập dữ liệu.

Cần cú pháp khác nhau cho những trình thu thập dữ liệu khác nhau

Hầu hết các trình thu thâp dữ liệu phổ biến sẽ tuân theo những cú pháp trong tệp robots.txt. Tuy nhiên, cũng tồn tại một số trình thu thập dữ liệu không tuân thủ theo chỉ định trong tệp vì không hiểu được các quy tắc trong đó. Như vậy, đối với các trình thu thập dữ liệu khác nhau có thể cần có những cú pháp khác nhau.

Không chặn việc thu thập dữ liệu từ người dùng

Nếu một người dùng có quyền truy cập vào trang web, họ cũng có thể thu thập dữ liệu từ trang web đó, bất kể robots.txt có chỉ định gì. Robots.txt chỉ áp dụng cho việc thu thập dữ liệu từ robot tìm kiếm và không áp dụng cho người dùng truy cập trang web.

Vì vậy, robots.txt có giới hạn trong việc kiểm soát việc thu thập dữ liệu và bảo mật trang web. Để bảo vệ tốt hơn trang web của bạn, nên sử dụng một sự kết hợp của các biện pháp bảo mật khác nhau và tuân thủ các hướng dẫn của các công cụ tìm kiếm.

Cách xem tệp robots.txt của một trang web

Có một số cách để xem tệp robots.txt của một trang web:

Thêm đuôi “/robots.txt” vào địa chỉ URL

Một cách là sử dụng trình duyệt web của bạn. Để thực hiện việc này, hãy nhập URL của trang web vào thanh địa chỉ của trình duyệt web của bạn và nhấn Enter. Sau đó, hãy nhập “/robots.txt” vào thanh địa chỉ của trình duyệt web của bạn và nhấn Enter. Nếu tệp robots.txt tồn tại, trình duyệt web của bạn sẽ hiển thị nội dung của nó.

Sử dụng Trình kiểm tra robots.txt

Một cách khác để xem website đã có tệp robots.txt hay chưa là sử dụng Trình kiểm tra robots.txt. Với trình duyệt Google, bạn có thể sử dụng Trình kiểm tra robots.txt trực tuyến. Điều kiện để sử dụng công cụ trực tuyến này là bạn phải liên kết website của mình với Google Search Console.

Sử dụng trình soạn thảo văn bản

Bạn cũng có thể xem tệp robots.txt bằng cách sử dụng trình soạn thảo văn bản. Để thực hiện việc này, hãy kết nối với máy chủ của trang web của bạn bằng FTP hoặc SSH và sau đó tải xuống tệp robots.txt vào máy tính của bạn. Sau đó, bạn có thể mở tệp robots.txt bằng trình soạn thảo văn bản để xem nội dung của nó.

Điều quan trọng cần lưu ý là không phải tất cả các trang web đều có tệp robots.txt. Nếu một trang web không có tệp robots.txt, thì trình thu thập dữ liệu của các công cụ tìm kiếm sẽ có thể truy cập tất cả các trang web của trang web đó.

Hướng dẫn tạo file robots.txt cho WordPress

Nếu website của bạn chưa có tệp robots.txt hoặc bạn muốn thay đổi tệp robots.txt thì có thể tham khảo một trong những cách sau đây:

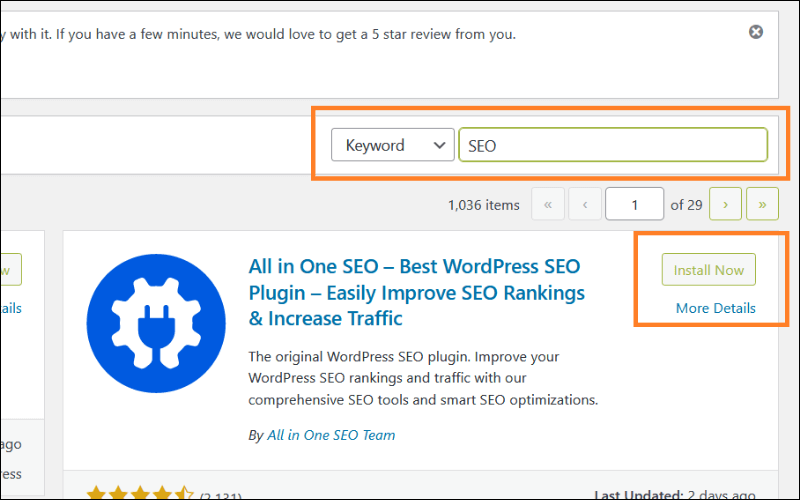

Dùng plugin All In One SEO (AIOSEO)

Plugin All In One SEO là một công cụ có thể giúp người dùng tạo được file robots.txt trên WordPress. Để tạo file robots.txt, bạn thực hiện theo các bước chi tiết sau:

Đầu tiên, bạn cần tải plugin All In One SEO về WordPress.

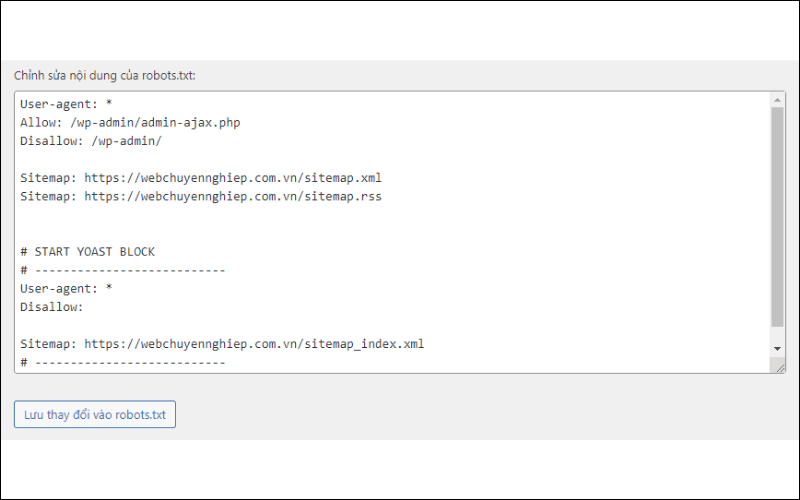

Sau khi tải xong, bạn nhấp vào plugin, chọn Tools. Để mở quyền chỉnh sửa robots.txt, bạn chọn “Enable Custom Robots.txt”.

Tiếp theo, khi kéo xuống bạn sẽ nhìn thấy bảng như hình dưới. Lúc này, bạn chỉ cần tạo lập câu lệnh robots.txt theo nhu cầu là xong.

Dùng plugin Yoast SEO

Yoast SEO là một plugin WordPress phổ biến cung cấp các công cụ và tính năng mạnh mẽ. Với Yoast SEO, bạn có thể tối ưu hóa các yếu tố quan trọng như tiêu đề trang, mô tả, từ khóa, URL và cấu trúc liên kết nội bộ. Bạn cũng có thể sử dụng plugin này để chỉnh sửa tệp robots.txt.

Trước hết, nếu chưa có plugin Yoast SEO thì trước hết bạn cần tải plugin này và kích hoạt. Sau khi tải xong, bạn tìm plugin ở thanh công cụ bên trái và nhấp vào, chọn Tools (Công cụ).

Bạn chọn tiếp File Editor (Trình chỉnh sửa tập tin).

Lúc này, bạn sẽ nhìn thấy 2 tệp robots.txt và .htaccess trên màn hình. Bạn có thể thêm hoặc xóa lệnh bằng cách chỉnh sửa trực tiếp trong ô và chọn “Save changes to robots.txt” là xong.

Dùng plugin Virtual Robots.txt

WordPress là một trong những nền tảng CMS khá hữu ích với nhiều plugin đa dạng có thể hỗ trợ cho nhiều mục đích khác nhau. Để tạo và chỉnh sửa tệp robots.txt, bạn còn có thể sử dụng Virtual Robots.txt. Đầu tiên, bạn cũng cần tải plugin về và kích hoạt.

Tiếp theo, bạn vào Cài đặt và tìm Virtual Robots.txt để nhấp vào. Bạn sẽ nhìn thấy ngay bảng lệnh robots.txt và có thể chỉnh sửa tùy nhu cầu và lưu thay đổi bằng cách chọn “Save changes” là xong.

Lời kết

Việc sử dụng robots.txt có thể giúp bạn bảo vệ thông tin riêng tư bằng cách hạn chế bot truy cập vào các nội dung không mong muốn và chỉ định nội dung cần ưu tiên thu thâp dữ liệu. Tuy nhiên, hãy lưu ý rằng robots.txt chỉ là một hướng dẫn và không phải một phương thức bảo mật hoàn toàn. Hy vọng bài viết trên của Miko Tech đã giúp bạn hiểu được robots.txt là gì và những kiến thức liên quan.

Trần Tiến Duy tốt nghiệp cử nhân chuyên ngành Thương Mại Điện tử tại trường đại học Sư Phạm Kỹ Thuật TPHCM. Từng Phụ trách mảng SEO Website tại nhiều lĩnh vực như giáo dục, công nghệ, thực phẩm, đồ dùng gia dụng, …v.v

Trần Tiến Duy hiện đang là Giảng viên Digital Marketing với chuyên môn chính là SEO tại trường Cao Đẳng FPT Tp.HCM.

Với hơn 7+ năm kinh nghiệm training & quản lý nhân sự về quản lý các dự án SEO/ Content SEO.

Hiện tại Trần Tiến Duy là SEO Manager tại công ty Miko Tech Agency chuyên về Thiết Kế Giao diện Website, với sự Quản lý của anh đã đưa Miko Tech trở thành công ty thuộc TOP ngành trên nền tảng Internet hiện nay. Ngoài ra anh Trần Tiến Duy còn đào tạo training nhân viên khoá học SEO Website nội bộ cho Doanh nghiệp giúp Doanh Nghiệp tối ưu tốc độ website phát triển kinh doanh mạnh mẽ hơn trong thời đại công nghệ số 4.0 hiện nay.

Anh Trần Tiến Duy còn chia sẻ miễn phí những Tool SEO hiệu quả giúp anh em SEOer tiết kiệm thời gian và được rất nhiều anh em trong giới SEOer và sinh viên sử dụng tại website: trantienduy.com/tool/